Mark Lucas

0

4615

1114

Si ejecuta un sitio web 10 maneras de crear un sitio web pequeño y simple sin la exageración 10 formas de crear un sitio web pequeño y simple sin la exageración WordPress puede ser una exageración. Como demuestran estos otros excelentes servicios, WordPress no es el principio y el fin de la creación de sitios web. Si desea soluciones más simples, hay una variedad para elegir. , probablemente hayas escuchado sobre un archivo robots.txt (o el “estándar de exclusión de robots”) Ya sea que lo tenga o no, es hora de aprenderlo, porque este simple archivo de texto es una parte crucial de su sitio. Puede parecer insignificante, pero puede sorprenderte lo importante que es.

Echemos un vistazo a qué es un archivo robots.txt, qué hace y cómo configurarlo correctamente para su sitio.

¿Qué es un archivo robots.txt??

Para comprender cómo funciona un archivo robots.txt, necesita saber un poco sobre los motores de búsqueda ¿Cómo funcionan los motores de búsqueda? ¿Cómo funcionan los motores de búsqueda? Para muchas personas, Google ES internet. Podría decirse que es el invento más importante desde Internet. Y aunque los motores de búsqueda han cambiado mucho desde entonces, los principios subyacentes siguen siendo los mismos. . La versión corta es que envían “rastreadores,” que son programas que buscan información en Internet. Luego almacenan parte de esa información para poder dirigir a las personas a ella más tarde..

Estos rastreadores, también conocidos como “bots” o “arañas,” encontrar páginas de miles de millones de sitios web. Los motores de búsqueda les dan instrucciones sobre dónde ir, pero los sitios web individuales también pueden comunicarse con los bots y decirles qué páginas deberían mirar..

La mayoría de las veces, en realidad están haciendo lo contrario y diciéndoles qué páginas no deberia estar mirando Cosas como páginas administrativas, portales de back-end, páginas de categorías y etiquetas, y otras cosas que los propietarios de sitios no quieren que se muestren en los motores de búsqueda. Estas páginas aún son visibles para los usuarios, y son accesibles para cualquier persona que tenga permiso (que a menudo son todos).

Pero al decirles a esas arañas que no indexen algunas páginas, el archivo robots.txt hace un favor a todos. Si buscaste “Hacer uso de” en un motor de búsqueda, ¿le gustaría que nuestras páginas administrativas se destaquen en el ranking? No. Eso no haría ningún bien a nadie, así que le decimos a los motores de búsqueda que no los muestren. También se puede usar para evitar que los motores de búsqueda echen un vistazo a las páginas que podrían no ayudarlos a clasificar su sitio en los resultados de búsqueda.

En resumen, robots.txt le dice a los rastreadores web qué hacer.

Los rastreadores pueden ignorar el archivo robots.txt?

¿Los rastreadores ignoran los archivos robots.txt? Sí. De hecho, muchos rastreadores hacer ignoralo. En general, sin embargo, esos rastreadores no provienen de motores de búsqueda acreditados. Son de spammers, recolectores de correo electrónico y otros tipos de bots automatizados que deambulan por Internet. Es importante tener esto en cuenta - Usar el estándar de exclusión de robots para decirles a los bots que se mantengan alejados no es una medida de seguridad efectiva. De hecho, algunos bots podrían comienzo con las páginas les dices que no vayan.

Sin embargo, los motores de búsqueda harán lo que dice su archivo robots.txt siempre que esté formateado correctamente.

Cómo escribir un archivo robots.txt

Hay algunas partes diferentes que se incluyen en un archivo estándar de exclusión de robots. Los dividiré individualmente aquí.

Declaración de agente de usuario

Antes de decirle a un bot qué páginas no debe mirar, debe especificar con qué bot está hablando. La mayoría de las veces, usará una declaración simple que significa “todos los bots.” Eso se ve así:

Agente de usuario: *El asterisco representa “todos los bots.” Sin embargo, podría especificar páginas para ciertos bots. Para hacer eso, necesitará saber el nombre del bot para el que está diseñando pautas. Eso podría verse así:

Agente de usuario: Googlebot [lista de páginas para no rastrear] Agente de usuario: Googlebot-Image / 1.0 [lista de páginas para no rastrear] Agente de usuario: Bingbot [lista de páginas para no rastrear]Y así. Si descubre un bot que no desea rastrear su sitio, también puede especificarlo.

Para encontrar los nombres de los agentes de usuario, consulte useragentstring.com [Ya no está disponible].

No permitir páginas

Esta es la parte principal de su archivo de exclusión de robots. Con una simple declaración, le dices a un bot o grupo de bots que no rastreen ciertas páginas. La sintaxis es fácil. Así es como no permitirías el acceso a todo en el “administración” directorio de su sitio:

No permitir: / admin /Esa línea evitaría que los robots rastreen yoursite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html y cualquier otra cosa que se encuentre en el directorio de administración.

Para no permitir una sola página, solo especifíquela en la línea de no permitir:

No permitir: /public/exception.htmlAhora el “excepción” la página no se arrastrará, pero todo lo demás en el “público” la carpeta lo hará.

Para incluir múltiples directorios o páginas, simplemente enumérelos en las líneas siguientes:

No permitir: / privado / No permitir: / admin / No permitir: / cgi-bin / No permitir: / temp /Esas cuatro líneas se aplicarán a cualquier agente de usuario que especifique en la parte superior de la sección.

Si desea evitar que los bots vean cualquier página de su sitio, use esto:

No permitir: /Establecer diferentes estándares para bots

Como vimos anteriormente, puede especificar ciertas páginas para diferentes bots. Combinando los dos elementos anteriores, así es como se ve:

User-agent: googlebot Disallow: / admin / Disallow: / private / User-agent: bingbot Disallow: / admin / Disallow: / private / Disallow: / secret /los “administración” y “privado” las secciones serán invisibles en Google y Bing, pero Google verá el “secreto” directorio, mientras que Bing no lo hará.

Puede especificar reglas generales para todos los bots utilizando el agente de usuario de asterisco, y luego dar instrucciones específicas a los bots en las secciones posteriores también.

Poniendolo todo junto

Con el conocimiento anterior, puede escribir un archivo robots.txt completo. Simplemente encienda su editor de texto favorito (somos fanáticos de Sublime 11 Sublime Text Tips para la productividad y un flujo de trabajo más rápido 11 Sublime Text Tips para la productividad y un Faster Workflow Sublime Text es un editor de texto versátil y un estándar de oro para muchos programadores. los consejos se centran en una codificación eficiente, pero los usuarios en general apreciarán los atajos de teclado (por aquí) y comenzarán a informar a los robots que no son bienvenidos en ciertas partes de su sitio.

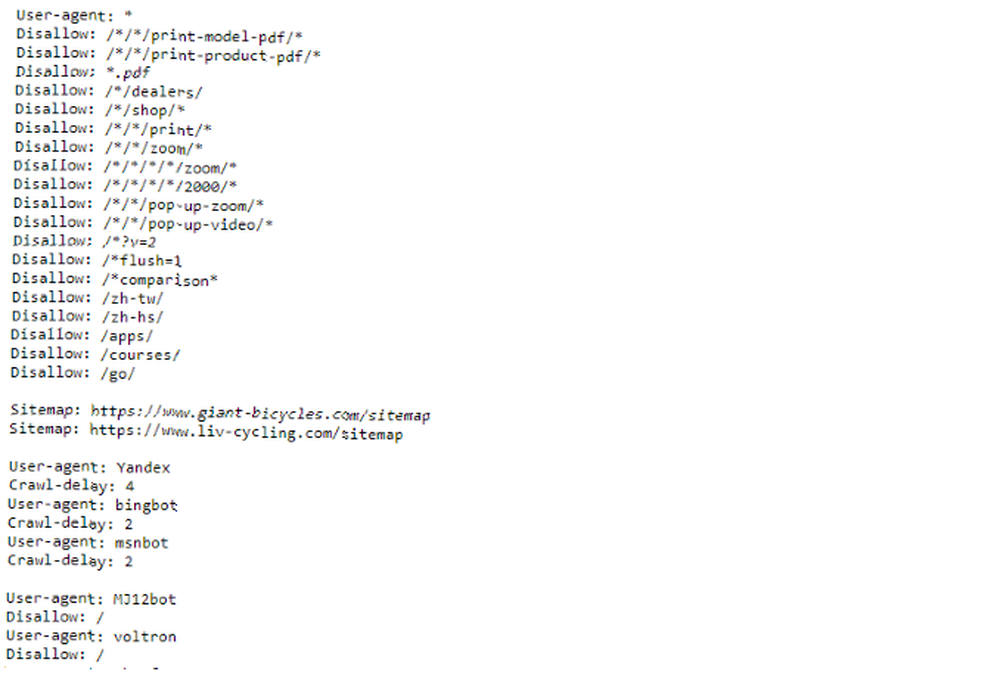

Si desea ver un ejemplo de un archivo robots.txt, simplemente diríjase a cualquier sitio y agregue “/robots.txt” hasta el final. Aquí hay parte del archivo robots.txt de Giant Bicycles:

Como puede ver, hay bastantes páginas que no quieren que aparezcan en los motores de búsqueda. También han incluido algunas cosas de las que aún no hemos hablado. Echemos un vistazo a qué más puede hacer en su archivo de exclusión de robots.

Ubicando su mapa del sitio

Si su archivo robots.txt le dice a los bots dónde no para ir, su mapa del sitio hace lo contrario Cómo crear un mapa del sitio XML en 4 sencillos pasos Cómo crear un mapa del sitio XML en 4 sencillos pasos Hay dos tipos de mapas de sitio: página HTML o un archivo XML. Un mapa del sitio HTML es una página única que muestra a los visitantes todas las páginas de un sitio web y, por lo general, tiene enlaces a esos ..., y les ayuda a encontrar lo que están buscando. Y aunque los motores de búsqueda probablemente ya sepan dónde está su mapa del sitio, no está de más hacerles saber nuevamente.

La declaración de una ubicación del mapa del sitio es simple:

Mapa del sitio: [URL del mapa del sitio]Eso es.

En nuestro propio archivo robots.txt, se ve así:

Mapa del sitio: //www.makeuseof.com/sitemap_index.xmlEso es todo al respecto.

Establecer un retraso de rastreo

La directiva de demora de rastreo le dice a ciertos motores de búsqueda con qué frecuencia pueden indexar una página en su sitio. Se mide en segundos, aunque algunos motores de búsqueda lo interpretan de manera ligeramente diferente. Algunos ven un retraso de rastreo de 5 como decirles que esperen cinco segundos después de cada rastreo para iniciar el siguiente. Otros lo interpretan como una instrucción para rastrear solo una página cada cinco segundos.

¿Por qué le dirías a un rastreador que no se arrastre tanto como sea posible? Para preservar el ancho de banda 4 formas en que Windows 10 está desperdiciando su ancho de banda de Internet 4 formas en que Windows 10 está desperdiciando su ancho de banda de Internet ¿Windows 10 está desperdiciando su ancho de banda de Internet? Aquí le mostramos cómo verificar y qué puede hacer para detenerlo. . Si su servidor tiene dificultades para mantenerse al día con el tráfico, es posible que desee instituir un retraso de rastreo. En general, la mayoría de las personas no tienen que preocuparse por esto. Sin embargo, los sitios grandes de alto tráfico pueden querer experimentar un poco.

Así es como establece un retraso de rastreo de ocho segundos:

Rastreo-retraso: 8Eso es. No todos los motores de búsqueda obedecerán tu directiva. Pero no hace daño preguntar. Al igual que con las páginas que no permiten, puede establecer diferentes retrasos de rastreo para motores de búsqueda específicos.

Carga de su archivo robots.txt

Una vez que tenga todas las instrucciones en su archivo configurado, puede subirlo a su sitio. Asegúrese de que sea un archivo de texto sin formato y que tenga el nombre robots.txt. Luego cárguelo a su sitio para que pueda encontrarlo en yoursite.com/robots.txt.

Si utiliza un sistema de gestión de contenido 10 Sistemas de gestión de contenido más populares en línea 10 Sistemas de gestión de contenido más populares en línea Los días de las páginas HTML codificadas a mano y el dominio de CSS, han quedado atrás. Instale un sistema de gestión de contenido (CMS) y en cuestión de minutos podrá tener un sitio web para compartir con el mundo. Al igual que WordPress, probablemente hay una forma específica en la que tendrá que hacer esto. Debido a que difiere en cada sistema de administración de contenido, deberá consultar la documentación de su sistema.

Algunos sistemas también pueden tener interfaces en línea para cargar su archivo. Para estos, simplemente copie y pegue el archivo que creó en los pasos anteriores.

Recuerde actualizar su archivo

El último consejo que daré es revisar ocasionalmente su archivo de exclusión de robots. Su sitio cambia y es posible que deba hacer algunos ajustes. Si nota un cambio extraño en el tráfico de su motor de búsqueda, también es una buena idea revisar el archivo. También es posible que la notación estándar cambie en el futuro. Como todo lo demás en su sitio, vale la pena revisarlo de vez en cuando.

¿De qué páginas excluye a los rastreadores en su sitio? ¿Has notado alguna diferencia en el tráfico de los motores de búsqueda? Comparte tus consejos y comentarios a continuación!